云巨头自研AI芯片升级 英伟达仍是永恒朋友?

集微网报道 在生成式AI的“号令”下,AI服务器成为服务器领域增长最快的细分种类,担当算力重任的GPU成为傲视群雄的硬通货。围绕这一红利云巨头定制芯片的节奏明显加快,最近微软两款为云基础结构设计的定制芯片——Azure Maia 100和Azure Cobalt 100闪亮登场,成为微软战略的重要版图。

这或是云巨头自研芯片新走向的又一个“典型”。无论是谷歌、亚马逊、微软、Meta还是国内的华为、阿里、百度等云巨头,自研芯片重心之一无不转向了AI芯片,由此与第三方供应商英伟达、英特尔、AMD等的竞合之势也产生了微妙的变化。

或许“朋友”的关系大于竞争?微软就坚定表示,作为定制芯片的补充,微软仍将拓展与英伟达、AMD等半导体厂商的合作,为客户提供多元化的基础设施选项。只是不知这份“亦敌亦友”的情谊能维持多久?

自研重心转向AI芯片

科技巨头自研芯片早已不是新闻,早在数年前亚马逊、谷歌、华为、百度、阿里等云厂商都已先后入局,并在CPU、TPU、DPU以及AI加速芯片等领域持续迭代。

但显然生成式AI浪潮引发的一系列“变局”让自研AI芯片变得愈加紧迫和必然。

当下先进GPU的数量决定了大模型企业能力的上限,围绕GPU已经展开了一场不断升级的“军备竞赛”,也让英伟达GPU成为业界“抢手货”。但受限于CoWoS产能短缺,供需严重失衡之下英伟达的H100价格也不断走高。前不久有报道称,英伟达的H100 AI加速卡的物料成本约为3000美元,而其售价已经达到了3.5万美元左右,甚至在eBay上卖出了超过4w美元的价格。云巨头不得不耗费巨资,也尝遍了被一家供应商所束缚的阵痛。

而GPU的荣光看起来仍将持续。Gartner在今年8月预测,全球AI芯片市场规模随着ChatGPT火热快速增长,到2027年就会达到近1200亿美元,是去年的2.7倍。

结合GPU的短缺、高昂成本和广阔前景,除微软之外,Meta、Google、亚马逊、特斯拉等英伟达的大客户今年都在投入更多资源研发AI芯片,甚至OpenAI都开始筹备芯片项目。

对于云巨头来说,自研AI芯片可减少“将鸡蛋放在一个篮子里”的风险,把握更多的自主权。此外,在云厂商热烈拥抱生成式AI之际,对云服务更加智能化、自主化、灵活化和可扩展化的需求也在与日俱增。英伟达的GPU属于通用芯片,与定制芯片相比虽然灵活度更高,但定制芯片的能效比和成本更优,可让云服务商在每个业务流程中做到效率与成本的最优化。

因云巨头大都拥有自己的AI模型和云服务,一个云服务器中存在多种芯片如CPU+GPU+DPU+各种定制芯片,相互协同工作效率才会更高,针对自己的堆栈做定制芯片,或能发挥更好的协同效应,效率也更高。

就成本而言,以Google的报价为例,使用其最新的AI芯片TPUv5e在训练、推理参数少于2000亿的大模型时,成本就低于采用英伟达的A100或H100。

英伟达仍是永恒朋友?

在云巨头相继下场向AI芯片腹地发起冲锋之后,与英伟达等厂商的关系会不可避免走向尴尬的“亦敌亦友”吗?

微软的表现或具指向性。再对整个云服务器堆栈进行了深入考察之后,微软倾力打造了定制化Maia 100 GPU和Azure Cobalt CPU,以优化性能、功耗和成本,自然有绝技傍身。尽管发布时间较晚,但Azure Maia却有后来居上之势。

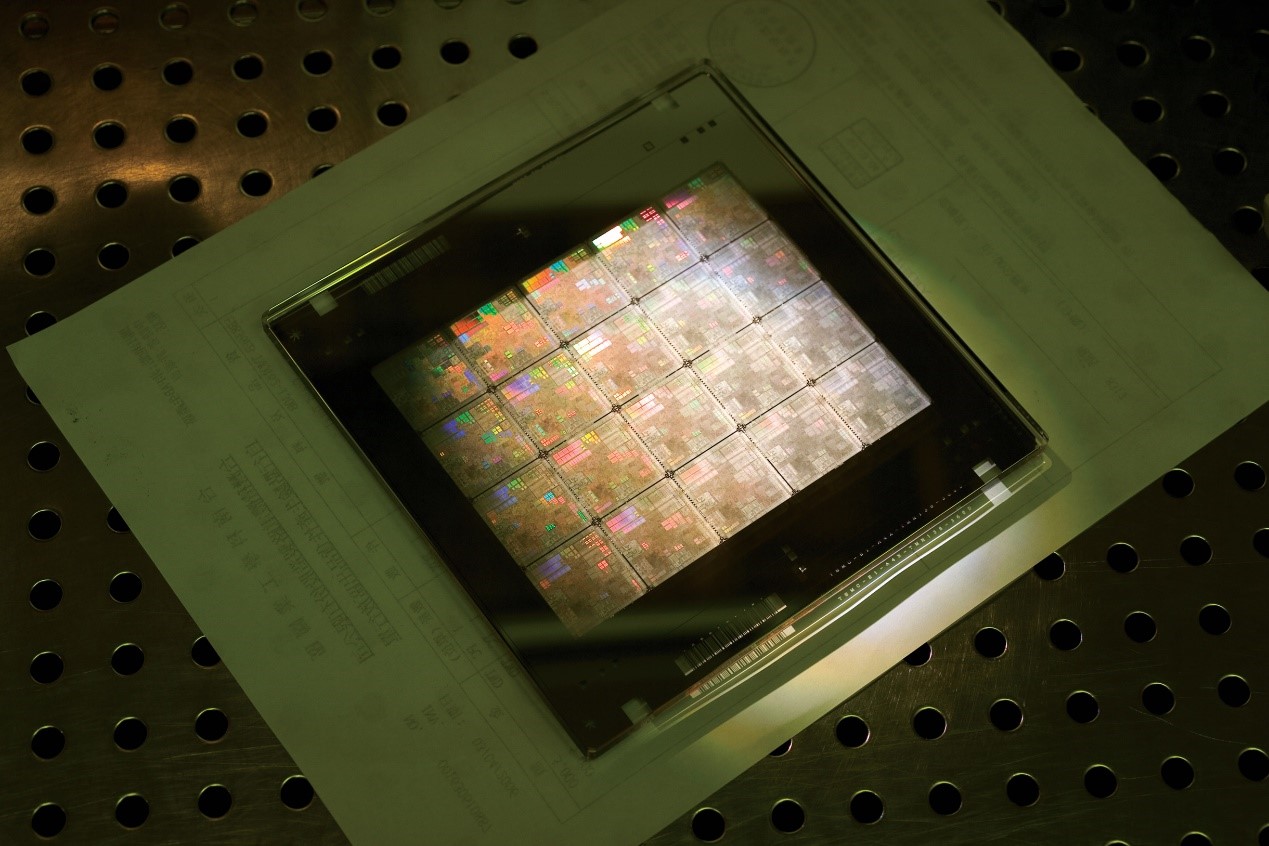

Azure Maia作为一款拥有1050亿个晶体管AI芯片,在算力方面能与英伟达(H100)和AMD(MI300X)一战,在网络I/O方面遥遥领先,而在显存带宽方面则稍显落后。与目前使用第二代Trainium/Inferentia2芯片的亚马逊相比,各项指标都实现了超城。Azure Cobalt为Arm架构的云端运算处理器,配备128个运算核心,与目前几代Azure Arm 芯片相比,效能提升40%。两款芯片均由台积电生产,微软已在设计第二代版本。

尽管自研两大芯片闪亮登场,但微软仍重申微软与英伟达和AMD的合作对于Azure AI云的未来很重要,黄教主也亲自站台助威。微软称双方不仅在硬件上强强联合,还宣布将英伟达AI代工厂服务(Nvidia AI Foundry)引入Azure,将英伟达的基础模型、NeMo框架、DGX Cloud AI超算以及服务全部集成到微软Azure平台,向企业和开发者开放。

用微软的话来说,就是微软致力于在云运行的规模上优化和集成堆栈的每一层、最大限度地提高性能、使供应链多样化,为客户提供基础设施的灵活性选择。

看起来英伟达仍是永恒的朋友?

某知名分析师对集微网表示,云巨头自研芯片虽然有优势,但可能大都只能是“备胎”,因为一直以来推动AI发展方向、都能配合的只有英伟达。尽管这些云巨头财大气粗,但开发的专用芯片侧重于特定场景,双方面向的市场并不冲突。

一家从事服务器开发的厂商代表也指出,云巨头自研芯片难以规模化商用,并不会改写现有的AI芯片市场格局。

但饶是如此,英伟达的江山也会面临一些蚕食之势。OpenAI曾表示,虽然今年GPU紧缺,但明年情况会更好,因Google、微软等公司自研的新款 AI 芯片将会投入市场,OpenAI已开始测试微软发布的AI 芯片。前不久,Google投资的Anthropic宣布大规模部署 TPUv5e,处理其大模型Claude的推理工作,这些任务原本属于英伟达的GPU。

未来走向未见分晓

尽管看起来GPU仍将享受AIGC这一“不世出”的红利,但也要看到的是,随着降低大模型的进入门槛愈发重要,硬件和算力层面的降本增效变得至关重要,GPU并不能一直“当红”。

在深存科技创始人&CEO袁静丰看来,为支撑大模型发展,新的计算与数据之间的关系也在发生变革,如果能做到比现有GPU架构更加高效且可降低计算成本,就能晋身成为AGIC时代的新钥匙。

袁静丰进一步认为,目前通用的GPU并非大模型时代算力的唯一最优解。有别于通用计算GPU往往要兼容数千个算子,大模型对于基础算子的要求并不多,只有数百个。大模型对于计算并非一定要追求通用性,而是更追求效率和成本方面进一步提升。跳出冯·诺依曼架构的存算一体架构可将计算单元与存储单元融合,实现数量级的计算能效提升,将大有可为。

此外,还要看到AIGC的进化方向对算力芯片的变革需求。

有分析称,在AIGC基建期,由于AIGC模型层的企业侧重于训练,高性能GPU成为主力;但在5年内进入中期阶段即AIGC开发期,在算力层由训练向推理倾斜,存算一体芯片、类脑芯片、硅光芯片将有更多市场机会,芯片也从GPU转向NPU/ASIC/FPGA/CPU等多种形式并存;随着未来走向商业期,芯片的底层创新优势开始显现,存算一体、光子芯片、类脑芯片等具备真正革新技术的芯片将一展身手。

从未来来说,大模型对于硬件和算力的需求,将给予第三方厂商的更多机会。

“互联网厂商自研芯片,既有目前GPU短缺和价格高企问题,也有效率不足的原因,是不得已而为之。最终会面临通用性、投入产出比以及产能到成本优势转换、供应链、硬件迭代能力等诸多挑战,芯片的研发需要高额的投入和长时间的积累,更需要长期大规模量产来摊销和降低成本。就长远来讲,这些芯片最后还是会回归到选择第三方独立芯片厂商的道路上来。”袁静丰最后笃定表示。

至于国内云巨头自研芯片的走向或许有不同的叙事,因受禁令影响国内买不到英伟达先进规格GPU,而自研芯片也不能超过一定“红线”,否则无法被代工。尽管有称针对新禁令英伟达为中国提供特供版H20,客户可多买几张堆叠弥补单卡算力不足的问题,估计2.5张H20可以等效于一张A100,但上述企业代表强调,这一观点并不可取。从长远来看,只有持续加大投入解决全产业链各个环节卡脖子的问题才是王道。